Replikationsforschung in Kooperation mit FORRT

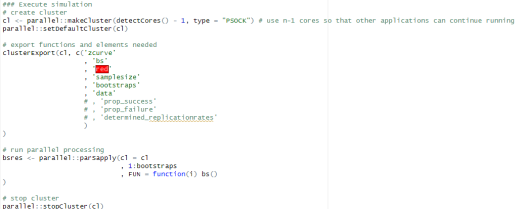

Hintergrund: Der „Scientific Record“ ist zu spannenden und überraschenden Befunden hin verzerrt. Replikationen, also die wiederholten Überprüfungen von veröffentlichten wissenschaftlichen Befunden, haben in den meisten Disziplinen, in denen sie sinnvoll und möglich sind, einen geringen Stellenwert. Zur Lösung dieser Probleme hat das MüCOS in Kooperation mit dem Framework for Open and Reproducible Research Training (FORRT) und gemeinsam mit Forschenden aus verschiedenen Disziplinen und mittels bestehender Datenbanken die weltweit größte Datenbank wissenschaftlicher Replikationsstudien erstellt. Die Daten werden live ausgewertet und sind frei verfügbar. Forschende können sich jederzeit durch die Ergänzung weiterer Replikationsbefunde beteiligen oder die frei verfügbaren Daten für eigene Untersuchungen nutzen.

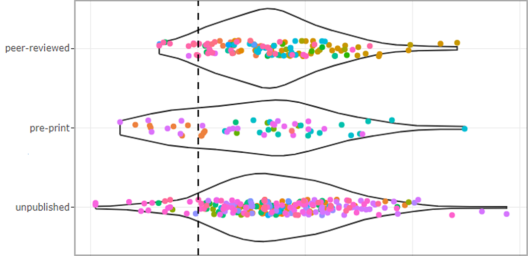

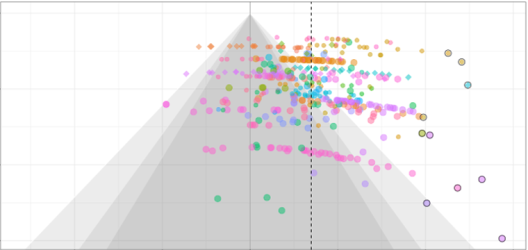

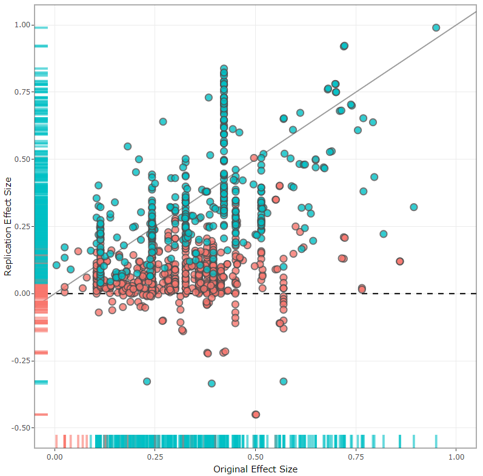

Zentrale Ergebnisse: Mithilfe der Replikationsdatenbank lassen sich zum Beispiel Erfolgsraten von Replikationsversuchen schätzen. Insgesamt liegt die Replikationsrate aktuell bei 50%. Das bedeutet, dass nur 5 von 10 Replikationsstudien zum selben Ergebnis wie vorherige Untersuchungen gekommen sind.

Weiterführende Informationen: Alle Projektmaterialien und Informationen sind online über die Datenbank verfügbar.

FORRT Replication Database

Framework for Open and Reproducible Research Training